type

Post

status

Published

date

May 28, 2023

summary

langchain简版教程附案例

slug

20230528

tags

工具

AIGC应用开发

Python开发

category

技术分享

password

URL

icon

简介

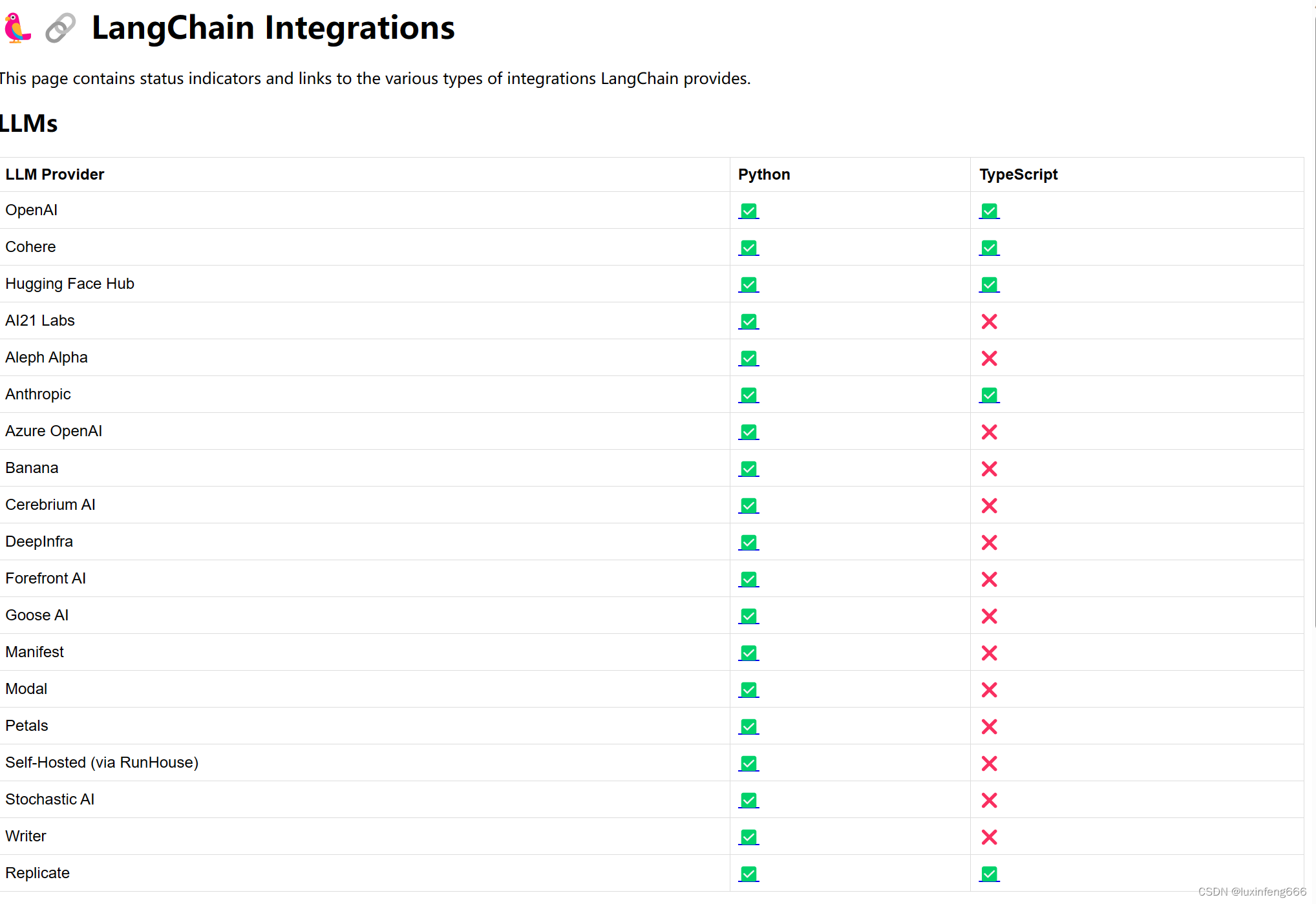

LangChain是一个开源的应用开发框架。基于该开源框架,我们可以把大模型与各种工具结合从而实现各种功能,比如基本文档的问答,解析网页内容、查询表格数据等。目前支持Python和TypeScript两种编程语言。当前Python框架支持的模型和功能最全面。

Modules

按照官方wiki的描述,可以将Langchain的支持的功能划分为以下几个模块。

Models

该模块主要是集成了多个模型。主要分为三类:

Large Language Models (LLMs)

Large Language Models是指使用深度学习技术训练的大规模语言模型,例如GPT-3、BERT、XLNet等。这些模型具有超过数十亿个参数,可以通过学习大量的文本数据,自动学习自然语言的语法、语义和上下文等知识。这些模型可以用于各种自然语言处理任务,例如文本生成、文本分类、问答系统等。由于这些模型的规模和能力越来越大,它们在自然语言处理领域引起了广泛的关注和应用,同时也带来了一些挑战,例如模型的计算和存储成本、模型的可解释性等问题。这些模型可以作为最近特别火的问答模型的基座。

截至当前,langchain共提供了以下模型的接口。

Chat Models

即问答模型,如chatGPT3.5等,这些可以理解为大语言模型的一种应用。

截至当前,langchain共提供了以下问答模型的接口。

Text Embedding Models

该类模型的作用主要是将单词、短语或文本转换成连续向量空间。转换为向量空间后,我们即可对这些单词、短语或者文本在数学上进行比较和计算。这种比较和计算在自然语言处理和机器学习中经常被用于各种任务,例如文本分类、语义搜索、词语相似性计算等。

Pompts

第二个模块就是我们熟知的Prompt提示。

langchain本身提供了多种Prompt模板,比如

ChatPromptTemplate模板,但是无论使用哪种模板,最终都是将拼接好的一段文字送入大语言模型。举个例子部分源码如下

其实际作用类似于Java中的String.format()

Memory

默认情况下,各类大模型都是无状态的,即没有上下文的概念。如果我们想在对话模型中实现上下文关联功能,就需要对聊天记录进行保存,然后每次请求时将之前的聊天内容传递给对话模型。langchain的Memory模块就是为了便于保存历史记录而设计的。langchain提供了多种保存方式,比如内存、向量数据库等。以下举了一个例子来说明Memory模块的方便性。

如果要自己实现这部分的话,就需要考虑如何设计存储历史记录,会更麻烦些。

Indexes

索引是指文本文档的一种存储方式,正常的文本文件无法直接与语言模型进行交互,因此我们需要做一下转换。在langchain中,转换的功能就是由Indexes这个模块实现的。

Indexes模块又可继续细分,细分为Document Loaders(文件加载)、Text Splitters(文本切分)、VectorStores(向量存储)、Retrievers(检索)四部分。

当我们需要提取数据时,就可以使用langchain提供的Retrievers模块去进行数据提取。Retrievers模块支持多种与信息检索相关的算法,比如• TF-IDF、• ElasticSearch BM25等,也支持我们常见的额机器学习算法如• kNN、• SVM。

Chains

我们可以把一个任务理解为一个chain,langchain支持我们自定义拼装chain,组成一条任务链,也就是chains。

Agents

Agents我们可以理解为代理人,我们可以理解这个模块可以帮助我们将任务分解,即可以根据用户输入的不同产生不同的任务链(chains),以下是一个官方案例。

输出为:

快速上手

安装Python环境

- 安装Anaconda https://www.anaconda.com/download

- 安装jupyter notebook https://zhuanlan.zhihu.com/p/33105153

- 安装langchain pip install langchain.如果pip安装比较慢,可以参考https://www.runoob.com/w3cnote/pip-cn-mirror.html使用国内的镜像源,推荐清华源。

具体案例-实现一个基于本地文本的问答机器人

该案例是在Jupyter Notebook上开发完成的。

安装相关依赖

测试输出

- 作者:luxinfeng

- 链接:https://www.luxinfeng.top/article/20230528

- 声明:本文采用 CC BY-NC-SA 4.0 许可协议,转载请注明出处。